ITVlue注:本文由几位戴尔易安信资深研究员或资深工程师联名撰写,文章主要指出了2020年服务器在七个方面发展的趋势和观察:

-

数据驱动的ML/DL/AI(包括来自边缘的数据)的集成,将为新的复杂业务提供重大业务影响;

-

服务器的下一波革命将是AI芯片的蓬勃发展,并在云中驱动核心到边缘空间。未来的系统将结合通用CPU和特定加速器,实现更多混合;

-

软件定义的这一趋势将加快客户从“云优先”策略向“数据优先”策略的转变,这导致x86服务器系统与卸载加速器(offload accelerators)结合在一起,成为承载边缘工作负载的基础平台;

-

全球数字化转型相关的计算解决方案的需求以及AI/ML/DL的兴起表明,未来的机架密度将远超过当今的密度;

-

现在芯片和封装方面的改进允许设备或元素由多个子CPU硅芯片组成,通常称为小芯片,且没有明显的性能或功耗缺点,还可以节省成本;

-

一个开放的行业标准软件堆栈生态系统,从BIOS和BMC到OS/系统管理程序再到应用程序层已经准备就绪;

-

容器生态系统中还可进行另一步优化,比如可以收集工作负载和基础设施利用率的遥测数据,并将其输入到调度和调度决策中。

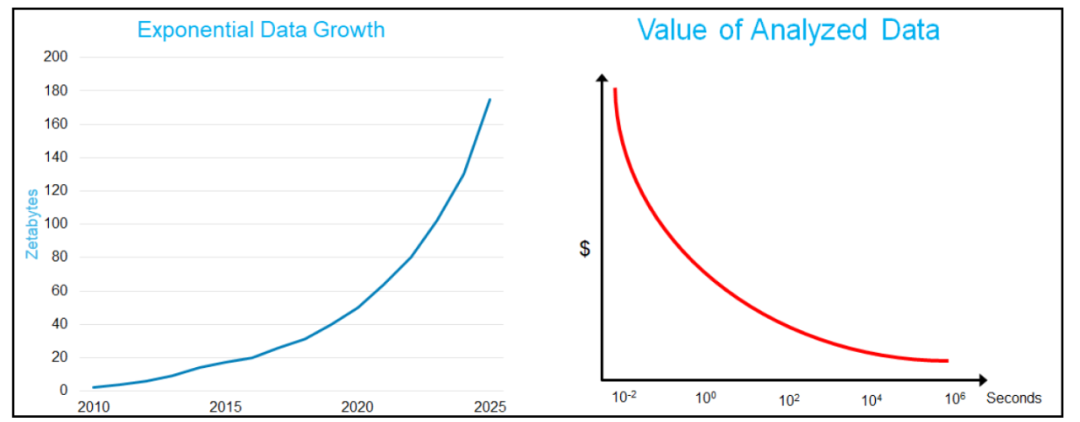

1、数据为王

数据是未来的关键,由数据驱动的见解正在改变业务的运行方式,并对从云到核心再到边缘的所有节点都提出了新的挑战。而大挑战来自于500亿个智能设备以及它们正在生成的大量边缘数据。

第一波数字化转型改进了工作流程,提高了生产率,同时还系统地将大数据纳入业务流程。但随着数据越来越多地推动业务发展,人工流程将难以推动下一波发展。

此时,以客户为导向的需求以及及时提供相关服务和产品的需求将数据科学推向了新的高度。采用通过数据自动方式驱动(即人工智能),是解决新出现的问题的唯一途径。

现代业务要求数据引擎以一种弹性,可伸缩和敏捷的方式存在,包括与现有数据源(如数据湖,分布式数据源以及现在不可复制的实时数据)进行互操作能力。

尽管数据科学和高级分析在算法和统计工作中继续占有重要位置,但由数据驱动的ML/DL/AI(包括来自边缘的数据)的集成,将为新的复杂业务提供重大业务影响。数据为王!掌握数据的人将领导世界。

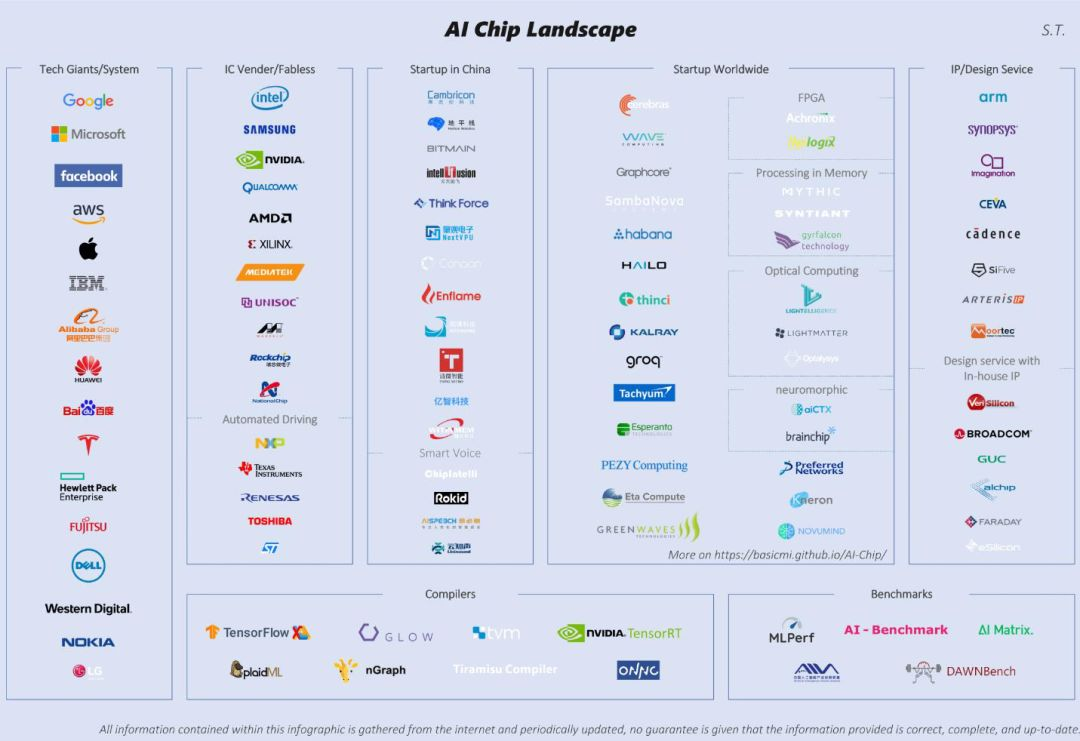

2、特定领域的CPU将加速崛起

CPU计算长期基于RISC或X86架构(IBM,Intel和AMD),而在过去的十年中,我们已经转向GPU和FPGA(Nvidia,AMD,Intel,Xilinx等)来推动AI/ML。现在,张量处理单元(TPU)和神经处理单元(NPU)越来越受到关注。

下一波革命将是AI芯片的蓬勃发展,并在云中驱动核心到边缘空间。

与传统CPU架构相比,人工智能芯片将有助于执行并行计算并更快地执行与人工智能相关的作业。与传统GPU和FPGA相比,这些芯片将更多应用于特定领域,例如计算机视觉,语音识别,机器人技术和自动驾驶汽车等。

另一方面,处理器供应商正在添加专门的指令(VNNI,Bfloat16等),以便能够更好地处理混合精度算法并优化AI性能。

与专用加速器相比,传统CPU为用户提供了更通用的平台,以供用户运行各种工作负载,并执行AI/ML/DL工作流程中必不可少的数据处理或数据准备任务。尽管在运行AI工作负载方面通用CPU的效率不如特定领域特定的加速器,但如果要将系统用于各种工作负载和用例,请考虑使用通用CPU的系统架构。

新一波的AI芯片浪潮引起了很多公司的成功。除了像Nvidia,Intel,Apple和Alphabet这样的大型公司之外,还有一系列新兴公司通过Graphcore,Groq,Hailo技术,Wave计算和Quadric等AI芯片来展现自己的存在。

预计该市场在未来2-3年内将增长到数百亿美元,并且随之而来的是许多参与者,他们将试图区分芯片、平台和应用并证明他们的优点。市场上大量的AI/ML用例使得这场竞赛趋于白热化。下一个游戏改变者将是使这些AI芯片更快,更有利于应用程序的人。大公司将必须努力保持敏捷,以在这场竞赛中生存,因为这是一场淘汰赛。

不过,不管谁赢了,用户都将有更多选择。未来的系统将结合通用CPU和特定加速器,实现更多混合。作为解决方案供应商,我们面临的挑战将是为正确的工作负载推荐正确的体系结构,并使我们的客户更轻松地操作和使用此类混合系统。

3、x86服务器扩展至边缘

大约10年前,SDN(软件定义的网络)和SDS(软件定义的存储)就开始朝着软件定义的体系结构发展。这产生了基于x86的标准服务器上运行块、文件和对象的新的横向扩展存储体系结构。

VMware vSAN,戴尔易安信VxFlexOS,ECS只是几个示例。网络体系结构也从专有网络演变为基于Open-flow的可编程交换机,以及用于VM和容器网络的新型分布式虚拟交换机。带有L4-7网络服务的戴尔易安信OS10网络操作系统,MicrosoftSONiC,VMwareNSX,LinuxOVS(开放虚拟交换机)和网络服务网格(NSM)只是其中的一些示例。大多数超大规模云和大型数据中心都是利用软件定义的架构构建的。

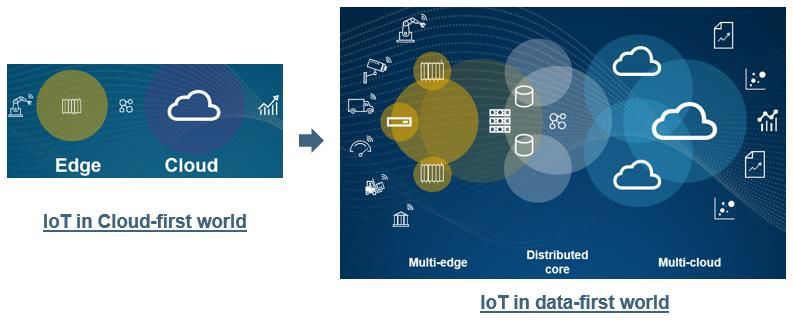

软件定义的这一趋势将加快客户从“云优先”策略向“数据优先”策略的转变,同时伴随着的IoT和5G也在推动这种转变。

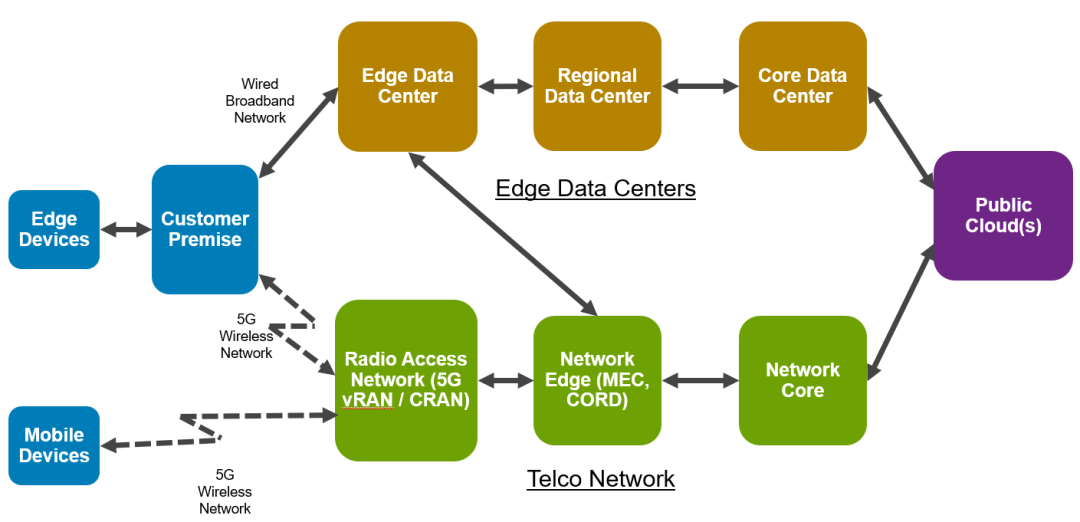

随着客户将IoT设备连接到网络,他们需要在本地或边缘处理数据。这些边缘位置通常需要坚固,紧凑且适用于严苛环境的设备。为了将数据处理应用程序移至边缘,底层基础架构服务(包括网络和存储)也需要移至边缘,以确保数据的安全性,私密性,并实现低延迟的数据分析。

这导致x86服务器系统与卸载加速器(offload accelerators)结合在一起,成为承载边缘工作负载的基础平台。x86服务器提供了连接到其他边缘和集中式公有云的边缘环境的能力,以实现数据的分布式处理。

为了实现移动用户(移动设备和联网/自动驾驶汽车)的连通性,电信公司正在朝着5G启用迈进,其5G基础架构也朝着软件定义演进。电信公司已经将其网络核心过渡到使用软件定义的NFV(网络功能虚拟化)过程中。

5G频谱的高速,低延迟和距离限制决定了蜂窝站点的密集化。这种密集化导致专有RAN(无线电访问网络)架构向CRAN/vRAN(集中式RAN/虚拟化RAN)发展,该架构也利用x86服务器,结合了RAN的卸载和对智能NIC和FPGA的网络处理。

总而言之,边缘的可扩展性,性能和多种用例将进一步加速“软件定义的基础架构”,因为所有工作负载都在服务器上运行。它还将推动特定领域架构(Domain-Specific Architecture)的需求。基础架构服务和用户应用程序的某些方面将被加速或卸载到专用的协处理器中,例如GPU,FPGA和SMART-NIC。服务器系统将由x86处理器和内存以及特定领域的加速器组成。

4、机架密度增加一倍以上

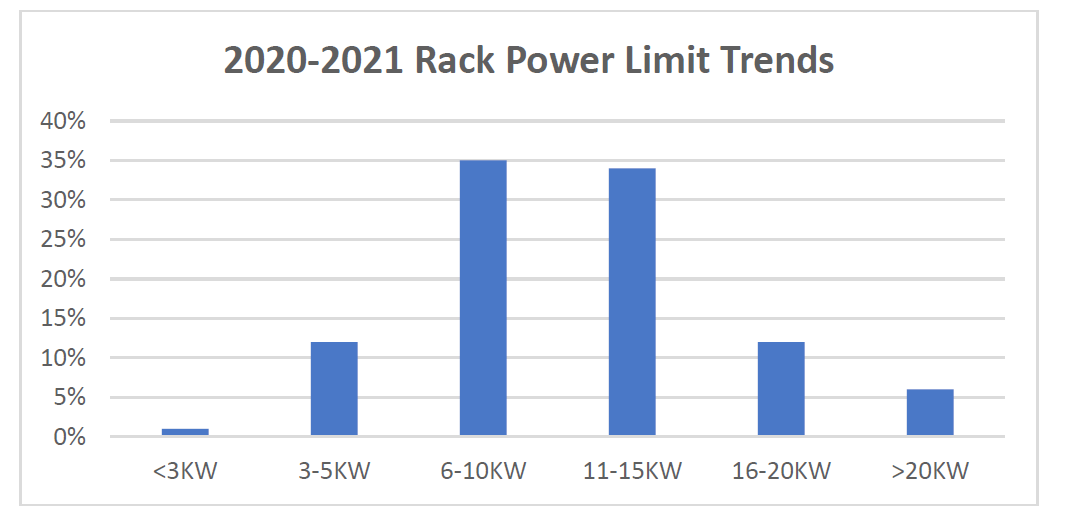

在过去十年中,机架功率密度一直保持相对不变。大多数专家都会同意,5-10kW的目标机架密度是对现有和未来硬件要求的保守评估。实际上,一项全球客户调查表明,大多数IT经理并不认为机架密度的增加会阻碍他们未来数据中心的增长和执行指标。

与全球数字化转型相关的计算解决方案的需求以及AI/ML/DL的兴起表明,未来的机架密度将远超过当今的密度。新的CPU/GPU在不久的将来每个超过300瓦、DDR5功率和通道数量增加、PCIeGen4/5功率和通道增加、100G+以太网,以及NVMe采用率的提高将下一代机架功率带入了新的领域。

如果客户希望维持现有环境,他们将很快面临关键的决定:

① 采用未来的服务器解决方案,但为了保持总机架密度而减少了每个机架的服务器数量;

② 转向使用低功耗服务器为了维持服务器节点数和总机架密度,或采用未来的服务器解决方案,因此相应地增加机架功率和数据中心功率以及散热。

一些客户认为,他们可以通过迁移到托管设备或公有云来解决这些挑战。然而,现实是,在那些地方也存在同样的挑战。

上图是保守的未来18个月内机架功率密度图,平均预计机架功率是现在的两倍以上。

数据时代就在眼前,AI,ML,DL已经来到了我们每个人身边,机架密度将增加一倍以上,边缘将带来许多新的机遇和挑战。

5、可扩展多CPU服务器时代到来

在10纳米及以下工艺的推动下,CPU核心数量,高速IO通道,DDR通道,嵌入式存储器和其他功能的增长速度超过了历史记录。今天,新的硅技术和基板封装方法,已经能够使我们以更加经济的方式扩展处理器。

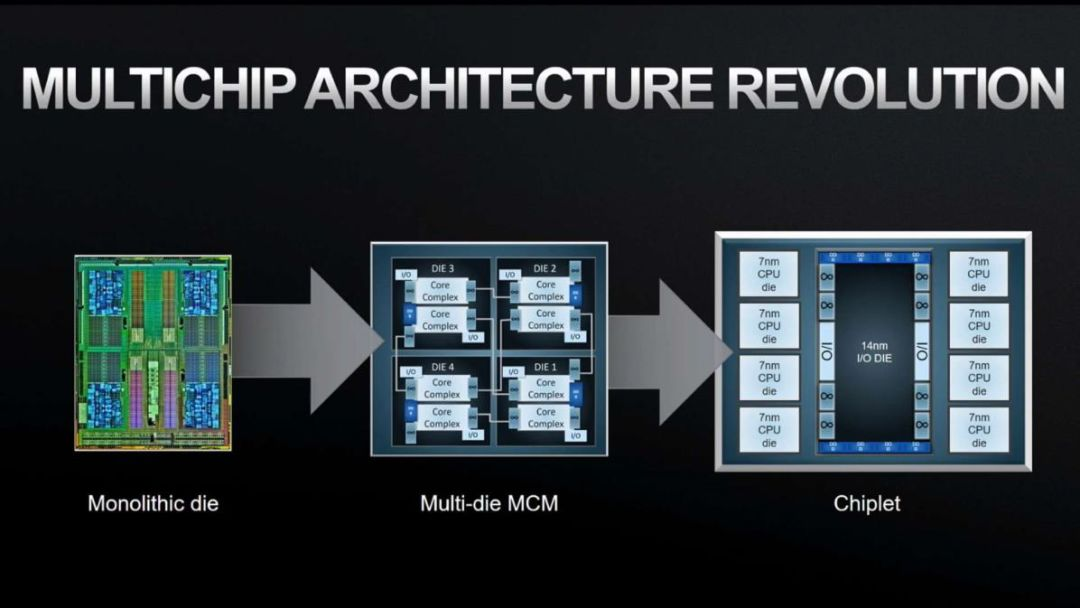

尽管多芯片模块(MCM)已经存在了好几代,但它们通常用于将封装内的多个分立器件芯片连接在一起,以节省空间或改善信号完整性。此时,芯片间互连的宽度受到限制,并且需要大功率I/O驱动器或SERDES。

但现在芯片和封装方面的改进允许设备或元素由多个子CPU硅芯片组成,通常称为小芯片,且没有明显的性能或功耗缺点。

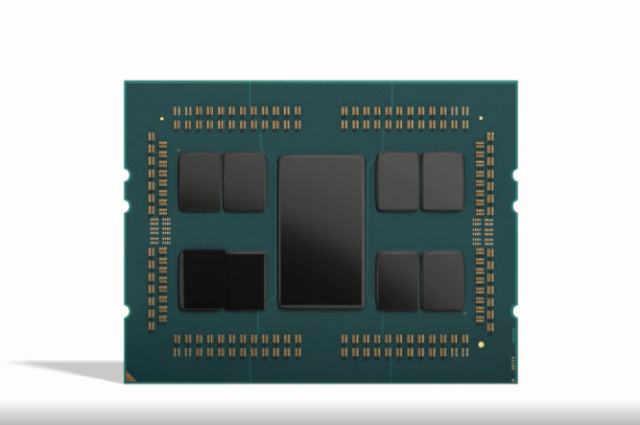

这种新方法的一个例子是AMD的第二代EPYC 服务器CPU,其中一个IO芯片(IOD)和多达八个8核CPU高速缓存芯片(CCD)以互连的方式布置在CPU封装基板上。

如果CPU是由单个整体式芯片制成,则CCD和IOD的数量不会对延迟或带宽造成任何明显影响。由于单个CCD和IOD芯片仅是等效单片芯片尺寸的一小部分,因此可以实现芯片成品率的大幅提高。此外,这种“小芯片”方法允许CCD使用比IOD更高级的硅工艺,从而节省更多成本。

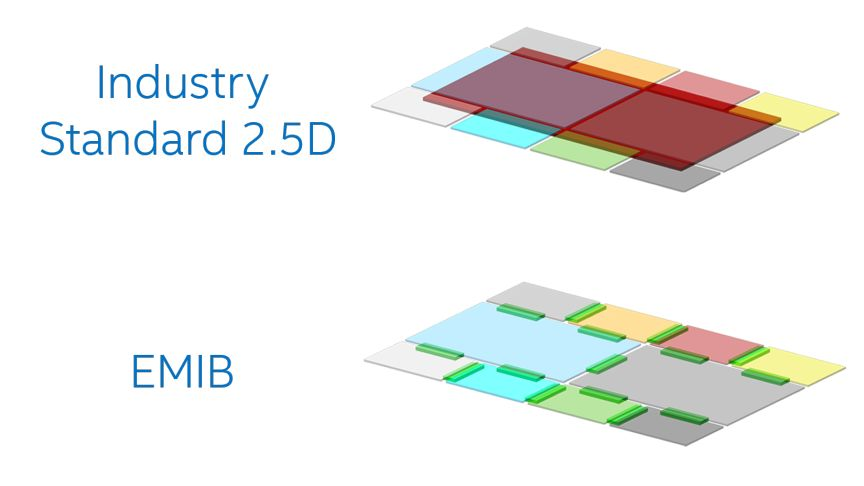

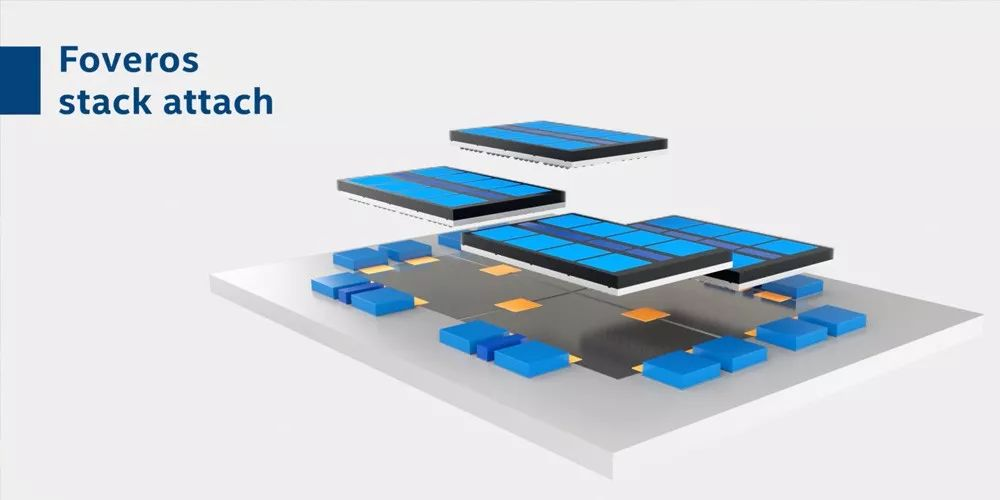

另一个例子是英特尔宣布的EMIB(嵌入式多芯片互连桥接)和Foveros(2D和3D芯片封装和堆叠)技术。

EMIB只需要一个小的嵌入式硅片连接,即可将两个小芯片绑在一起,并具有高带宽和小距离。EMIB并未在英特尔的FPGA和Kaby Lake-G中使用,它将GPU连接到封装内的高带宽内存。

Foveros是一种硅堆叠技术,它使用TSV(通过硅通孔),例如,可以有效地连接独立的IO,内核和存储芯片。在某些情况下,硅叠层底部的芯片充当有源“插入层”或基板。

6、SCM道路已成

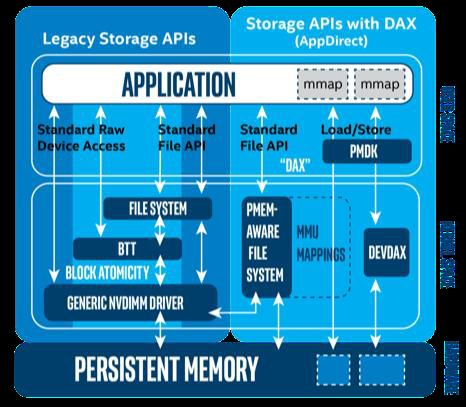

实现无处不在SCM的所有必要要素都已经准备就绪。

随着行业标准NVDIMM获得多源和广泛的CPU支持,专有的非易失性DIMM消失了。接近DRAM级的存储级内存(SCM)介质(如英特尔Optane DCPMM DIMM)已经到货,从而支持新的本机非易失性持久性内存使用模式,以及更高的容量和更低的$/GB。

至关重要的是,一个开放的行业标准软件堆栈生态系统,从BIOS和BMC到OS/系统管理程序再到应用程序层已经准备就绪,以确保将当前和新的持久性内存类型轻松地引入通用框架。

适用于服务器的持久性内存的其他SCM介质类型和变体也将出现,包括相变存储(PCM),自旋转矩磁阻RAM(ST-MRAM),碳纳米管(CNT或NRAM)和可变电阻式存储器(ReRAM),将在容量,耐用性,成本和性能方面提供更多选择。

当我们展望2020年及以后时,该行业将从今天主要是针对早期采用者的市场(例如存储,数据库和服务器设备)转向更通用的计算部署,在这些计算部署中,持久性内存可改善整体系统成本,性能,容量,引导以及恢复时间,耗电量等。

7、关于容器

从服务器设计的角度来看,我们一直有考虑将要在服务器平台上运行的软件,确保这些软件能与处理器,内存和I/O很好的配合 ,以支持工作负载。

现在,随着可组合和灵动架构设计的开始,软件可以动态地利用其所部署的硬件。我们看到容器能够通过对应用程序基础架构感知来使用硬件功能,这使开发人员能够将应用程序行为与特定服务器平台功能结合起来,并大程度地提高结果。

但是,容器生态系统中还可以进行另一优化步骤,比如在一辆运行的列车上部署容器化应用程序时,可以收集工作负载和基础设施利用率的遥测数据,并将其输入到调度和调度决策中,以确保已部署的作业在越来越优化的平台上运行。

我们将通过收集到的遥测数据,结合基于动态硬件利用率结果制定更好的容器调度决策。这种协作将在新的调度算法和动态硬件部件的组合中体现出来。在未来,平台基础,平台资源,工作负载和组合引擎将通过遥测指标与调度程序交织在一起。

声明:转载此文是出于传递更多信息之目的。若有来源标注错误或侵犯了您的合法权益,请作者持权属证明与本网联系,我们将及时更正、删除,谢谢。

塔式服务器

塔式服务器  机架式服务器

机架式服务器  刀片式服务器

刀片式服务器  Precision工作站

Precision工作站  存储设备

存储设备  塔式服务器

塔式服务器  机架式服务器

机架式服务器  塔式服务器

塔式服务器  机架式服务器

机架式服务器  刀片服务器

刀片服务器  图形工作站

图形工作站